■ OBS Studio

無償で使用できる配信ソフトに

■ OBS Studio

https://obsproject.com/ja/welcome

がありますが、今回はOBSについて書こうかなと思います。

O BSについて

OBSは、無償で利用できる配信ソフトですが、このソフトでは、

■ 配信

■ 録画

が行えるようになっています。配信と録画だと、WINDOWS 10から自社製のゲーム機のXbox Oneシリーズに合わせて、Xbox Game Barが実装されたのですが、この機能を使うと、同様のことが 【 標準機能 】で行えますが、OBSの場合、 【 素材の合成 】 までできるので出来る事が多く存在するという利点があります。OBSでは、

■ 画面の登録

■ 画面の切り替え

■ トランジションの追加

■ フィルターの追加

■ 色補正

■ 素材の合成

■ テキストの追加

■ 入力素材の追加

などができます。

その為、完全に 【 ソフトウェアスイッチャー 】 そのもののような動作をしてくれます。

この機能を追加して動いているフレーム内の状態を記録できるので、キャプチャーとしても使用できるのですが、配信の状態のようなフレーム内の状態を作って実況を行って素材の録画をして、その素材を元に使う部分だけ残して編集していくという方法もあります。

その為、後から処理で追加したほうがいい物もありますが、配信画面と同じ状謡の素材で録画を行って、それを素材として用意しておいて中間ファイルを作っておき、そこに素材を重ねて映像を仕上げる事もできます。この場合、

■ ワイプ

■ 実況音声

■ ゲームの画面と実況音声

を入れた状態で録画が出来る(と言うか、アバターではなく実写だと現在はPS4やPS5でもこの状態で素材の記録ができます。)ので、その素材を元に実況動画を仕上げて行く事もできます。

O BSとパフォーマンス

OBS関連だと、ArderlakeのCore i9を使った場合、画面の品質の調整は必要ですが、ゲームプレイをしている状態を配信し、それをバックグラウンドで録画するような処理をしてもfps数がある程度出てしまうという物凄い仕様になっています。同アーキテクチャのCore i5だとタイトルによってはコマ落ちが発生するので最適な録画が出来ないようになりますが、現在の最新のアーキテクチャだとこう言った処理をコンシューマのデスクトップPCだけで行える仕様になっています。

■ 配信時の負荷の低減

配信ソフトを使う時に配信ソフト側の付加を下げると、メモリーの容量やCPUの付加を下げる事が出来るので、処理自体をゲーム側に割り当てる事が出来ます。基本的に、メモリー消費量やCPUの演算は、実行しているソフトで必要とするメモリーの消費量や演算の量を合算した物になりますから、ゲームで手一杯の状態だとOBSを立ち上げるとゲーム自体がコマ落ちしますし、処理能力が足りない場合には、録画段階でコマ落ちします。

その為、 【 1080/60fps 】 とか 【 2160/60fps 】 で絵う遺贈素材を得る場合には、全ての処理を行って大丈夫な環境を作る必要があります。そう考えると、ゲーム自体のpsが下がっても60fps辺りが担保できる状態で録画も適正に行えるような負荷でなければ、PC内でゲームの実行が出来ないので、事前に何が出来て何が出来ないのかを知っておく必要があります。

この条件で考えると、2160/60pでゲームをして素材を得るとか配信を行うような条件だと結構ハイスペックなマシンが必要になりますし、現在のおいてAAAタイトルの物だとそれ相応の、マシンスペックが必要になります。

OBSは、ソフトウェアスイッチャーと同じなので、リアルタイムで演算をして素材の合成をしてレンダリングを行って配信を行っている訳ですが、構造はハードウェアのスイッチャーと同じなので、入力をした物を合成する処理を行っています。

その為、BlackMagicDsignのATEMシリーズなどと同じ処理をしている事になります。ATEM miniと言う配信用で入力切替が出来るような製品も出ているので、複数の画面を用意してカメラの映像とモニターの映像を切り替えて配信する事が出来る成否も出ていますが、この製品ではPinPも可能なので、2つのカメラの映像を重ねたり画面の映像とカメラの映像を重ねる事もできるようになっています。

OBSは、この機能を多機能にしてストレージ内にある素材も含めて入力が複数用意できるような構造になっているので、SSDを高速にしておくと素材の呼び出しが速くなるので、処理を高速に行えるようになりますが、映像や音声入力をSDIやXLRで入力しているのをストレージ内の素材で行えるような仕様になっています。

なので、スイッチャーを使ったことがある人だとソフトの使い方を覚えると、 【 ソフトウェアスイッチャーその物 】 でしかないので、画面の登録と呼び出しまでできたり呼び出し遅延をトランジションでごまかしたりもできるのでかなり自由度の高いツールだという事が解ります。

ハードウェアスイッチャーの場合、スイッチャー内部で信号の処理をしているので、出力段階でその設定の映像を出力できる仕様にな手ちますが、現在の個人向けのスイッチャーの映像入力はアナログではなくデジタルなので、HDMIで取り込むことができます。この規格は、映像と音声をセットで出力できる規格なのでゲーム機の映像やカメラで録画している映像なども映像と音声が一つのケーブルで伝送される仕組みになっています。

コンシューマのスイッチャーも同様にHDMI入力とHDMI出力なので、HDMIでの音声の入出力が可能なので、HDMIキャプチャーがあれば、スイッチャーで制御している信号をそのままPC側に送る事ができます。

PCレスの環境で考えると、

■ ハードウェアのスイッチャー

■ 外部レコーダー

■ モニター

と言う構造になるので、スイッチャー側でモニター出力と外部レコーダーへの記録を行うようにして、モニターで映像を確認して状態を作って録画をすると、入力した物を切り替えながらレコーダーに記録する事ができます。

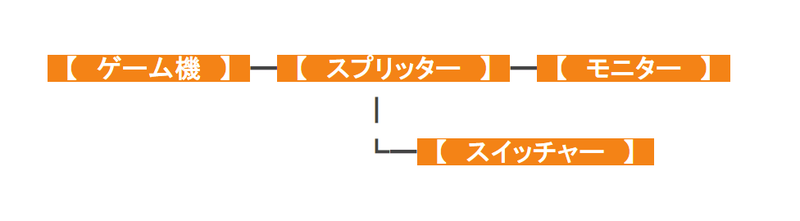

つまり、この構造でゲーム配信をスイッチャーのPinPの機能を使って行う場合、OBSに出力するのは、スイッチャーからの映像にできるのですが、

と言う構成にすると、ゲームの遅延が殆どない状態で、モニターに映像を表示できて、更に、スイッチャー側にゲーム画面を入力できます。

この状態で、スイッチャーに

■ カメラ映像(映像・音声)

■ ゲーム画面(映像・音声)

■ マイク(音声)

■ プレイヤー(音声)

のように接続しておくと、素材が揃うので、PinPの映像やカメラだけの映像の切り替えが出来るようになります。その為、

■ カメラ映像

■ ゲーム画面+カメラ映像(クロマ+ワイプ)

のような感じの物を切り替えて配信の構成が行えるようになります。

この状態で、スイッチャーの入力した物を制御する場合に、フィジカルコントローラーが必要になる訳ですが、これを用いる事で、トランジションなどの効果を制御できるようになります。

こうした機能を使わずにぶつ切りな感じで切り替わる状態だと、スイッチャーだけでも大丈夫ですが、この映像を配信する場合、別途

■ HDMIの映像を配信できるハードウェア

■ モニター

が必要になります。

配信用の機材は、そのものですからいいとして、なぜモニターが必要なのか?と言うと、 【 配信で出力している映像の確認用 】 になります。これにインタネット接続環境があって、アップロードの速度がしっかりと出る条件で回線を契約する必要があるので、結構コストがかかります。YouTubeに動画をアップする場合、何が必要なのか?と言うと、ベストエフォートでアップロード時にそこそこ速度が出てくれる条件であればいいのですが、配信になると、安定してビットレートが担保できないと配信はできません。と言うのも、配信の場合、アップロードですから、サーバ側にデータを送っている状態なので、下り回線が速度があっても上り回線が遅い場合には安定した配信が出来ません。

その為、配信で必要になる回線と、インターネットのコンテンツを快適に見るという目的の回線では選択が違ってきます。

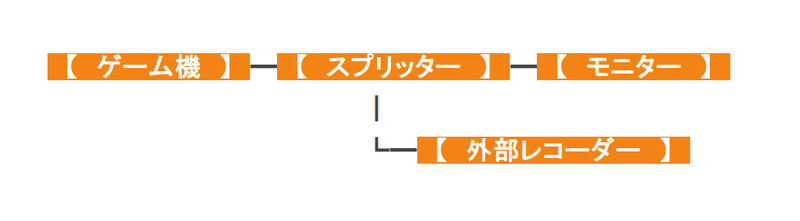

この回線を用意して配信を行うと、スイッチャーの操作で作った映像がそのまま配信されるようになります。ただし、この映像を編集して動画にする場合だと、

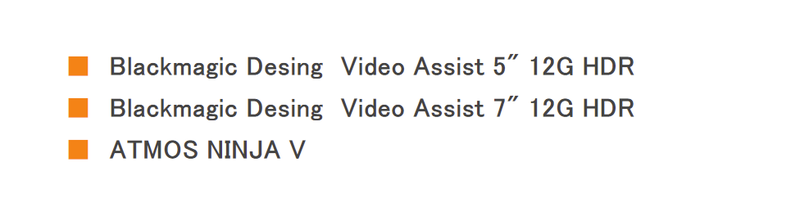

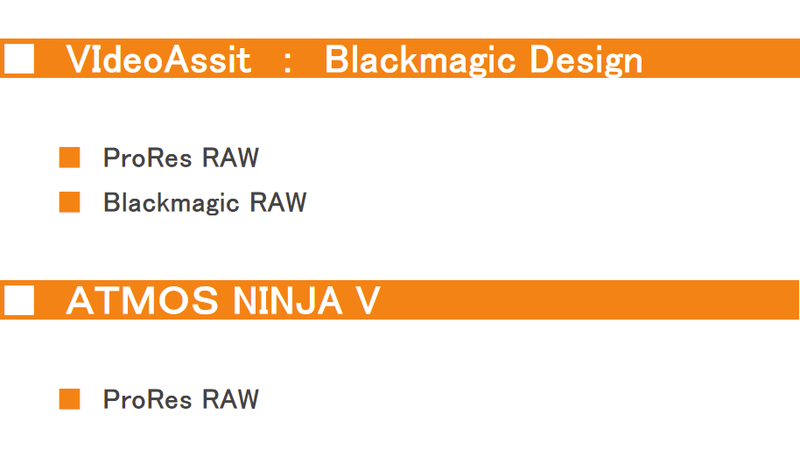

と言う風に分岐して、配信内容を録画する事になります。この時の選択肢ですが、個人の場合で、8bit/:4:2:2のREC.709 のフルHDで大丈夫な場合だと、比較的低価格なスタンドアローンでUSBのストレージに記録できる製品もありますから、ストレージとそう言った製品を使う事になりますが、12bitの業務用のソースで記録sる条件ででPCレスの物を記録する場合だと、

などを使う事になります。ちなみに、

での記録が行えます。この状態だと、スイッチャー頼みになりますが、ATEM miniのような製品だと入力数が決まっているので、どう言った作り方をするのかで入力の使い方が変わってきます。

この構成にすると、

■ 映像の記録

■ スイッチャーでの画面の状態の構築

■ 配信

ができます。音声で同じような事を行う場合だと、 【 ミキサー 】 を使って入力巣を増やして音声をステレオでスイッチャーに流すような流れになりますが、これを行うと、

■ 音声の管理 : ミキサー

■ 映像の管理 : スイッチャー

で行う事が出来ます。そして、こうしたハードウェアを行うとミキシングの処理に全くPCを使っていないので、個々の段階で、HDMIで出力される音声と映像はゲーム画面やカメラで撮影している映像を入力した時と同じ負荷で扱う事が出来ます。

OBSを立ち上げて、映像入力をして配信をするだけだとそれほど負荷が上昇する事はありませんが、スイッチャー側で複雑な処理をしたり素材の読み込みが発生すると、HDDの選択が消えるので、SSDの構成の一択になります。しかし、この映像と音声の合成が出来ている場合だと、一つの映像素材として完結しているので、負荷が上昇する事はありません。

この素材に対して、テロップを入れたり、元から用意していた

■ OP

■ ED

■ 待機

の素材を切り替える事もできます。このように、入力しているHDMIの信号自体をスイッチャーで合成しておいて完成させておくと、ソフトウェアスイッチャーとして働いているOBS側で発生する負荷を下げる事が出来るので、ゲーム映像に色々な素材を合成した状態の物を再生しながら録画をする事もできるようになります。

コスト的に個人では結構厳しい状態になりますが、スイッチャーを使う場合、マルチプレイの時に複数人のワイプを入れる事もできるので、スイッチャーを使うと色々な選択肢が増えますが、そうした処理をOBS側で行うのは負荷的に無理が来るので、そうした場合の対処を考えると、スイッチャーで合成して、OBSで不足した情報を合成して配信すると、PCでの負荷を下げて複雑な画面の状態での配信が行えるようになります。

O BSと素材

アニメーション背景を作る場合、モノクロで作ると色を乗せやすい(乗算処理のイメージになります。)ので、モノクロのループ素材を作ると、フィルター処理で色を乗せる事が出来ます。その為、ドット柄の背景を用意する場合に、モノクロで作ると素材の色を目的に応じて変える事が出来ますし、動きがある場合だと、始点と終点が繋がるような素材の作り方をするとループ再生をする事もできますから、その素材の色を変える事もできます。この上に透過素材を重ねて行く事になりますから、アバターだとクロマキーで抜くことになるので、背景色がアバターの色と被らないような物を用意しておいて、素材の合成をすることになります。

その為、3Dアバターはレンダリング結果なので、ピクセルの集合体のラスターグラフィックとして素材に配置する事になるので、リアルタイムで動く場合だと、アバターを動かすツールを使って映像として取り込んでそれを素材として重ねた物をクロマキーなどで透過して動かすような流れになります。映像の場合だと、デコードで済むのですが、ゲーム配信でAAAタイトルを動かして、OBSを起動し手素材を重ねて、更に、アバターのリアルタイム処理まで行うと、流石に無理が来るので、こうした負荷が密集するような条件だと分散させる必要が出てきます。

そう考えると、アバターの演算の負荷を別の端末で行って、それを映像と言う形で読み込んだ方が付加が減るので、

■ アバター

■ 負荷のかかる処理

を考えると、負荷の分散が必要になります。映像をライブ配信する場合だと、 【 遅延 】 の問題もありますが、結構負荷がかかる処理が多いので、 【 負荷の分散 】 の方法も考える必要があります。

個人の場合だと、PCで配信が可能か否か?の確認から始まりますが、リソースが違うので、マシンごとに出来る事が違います。

配信については、文教用の端末では無理なので、結構ハイスペックなマシンが必要になるので、コストがかかる分野になりますが、入力数が増えると単一の端末での処理が追い付かなくなるので、アバターを含めた処理の応用と同じで映像素材として外部入力をして負荷を下げたり、スイッチャーで素材のレイアウトを決めておいてそれを読み込むことで負荷を下げる方法を考える事になります。

動画制作だと、プレビューが出来る環境であれば問題がないので影響が出ないのですが、配信の場合、ゲームと同じようにリアルタイムで動く状態が必要になるので、何をすればその挙動が実現可能なのか?を考えて負荷とラグのコントロールをする必要が出てきます。

O BSとパフォーマンス

あと、OBSで実装されているCUDAを使ったGPUエンコードですが、この処理は、高速なレンダリング処理が出来るのとCPUの負荷をかけずにエンコードが出来るという利点がありますが、bニットレートを下げた場合、実写だと荒れる傾向があり、CGだと荒れにくと言う利点があるので、ゲーム画面などのようなグラフィックには向いているエンコード方法になります。あと、こうした処理を行う場合にはVRAMが多いほうがいいので、VRAMの多いGPUを用意する事になります。そうすると、必然的に上位のGPUを選ぶことになりますが、メガタスクで絶望的に重くした場合には、いずれかのタスクに弊害が出てしまうのですが、今後のアーキテクチャは、驚くような処理が出来るようになっているので、合成なしでゲーム画面と音声を用意して録画とストリーミングの同時起動を行ったとしても対応できてしまうような状態になっています。

このメリットですが、 【 実況映像をそのまま配信して、アーカイブをアップロードする時に、編集用のソースが配信後に残っているので、これを編集して比較的早期に、まとめ動画や編集したダイジェスト動画をアップロードできる 】 と言う利点があります。PinPまで入れて、いろいろしてしまうとPC内でゲームを動かして行う場合に、AAAタイトルが除外しなくてはならなくなるようなグレードもある(Core i5とか)もありますが、この辺りは、今後のBIOSやファームウェアやOSのアップデートなどで変わってくるかもしれませんが、現状だと、メガタスクでもデスクトップで対応できるようになっていて、第12世代の製品が結構性能が高くなっている傾向があります。多分、現在の状態でもCore i5が結構凄い事になっているので、このグレードでも重たい処理をさせるとこのグレードらしからぬ動きをしてくれます。

当然、AMDのCPUにも期待がかかるところですが、DDR5はZEN4からですから、AlderLakeの 【 DDR5にすると電力が跳ね上がる傾向 】

がなくなって、メガタスクに対応できるようになると、前の世代の製品の魅力がなくなるので、DDR5にシフトする状態になると思います。(と言っても、半導体不足の解消と流通の安定化があっての話になりますが...。)

ARM関連だと、QualcomがARMベースで高性能なSoCの開発に着手しているようなので、AndroidユーザーやARMベースのWINDOWS端末なども高性能になって行く事になりそうです。こうした端末でメガタスクの長時間運用だと厳しいので、ARMの高速化とメガタスク用の高速化は少し違うカテゴリーになりますが、この双方で現在よりもさらに高速なプロセッサやSoCが登場する予定になっています。

ちなみに、AMDのZEN5は3nmプロセスになるようで、ZEN4世代のAPUはRDNA2世代のGPUが実装されるようです。

━━━━━━━━━━━━━━━━━━━━━━━━━━━━

■ 個人の作業とメガタスク

━━━━━━━━━━━━━━━━━━━━━━━━━━━━

コンピューターについては、1990年代はシングルスレッドの時代で、ソケット数でスレッドを増やす状態でしたが、2005年くらいまでのコンシューマのCPUでSMTを持った製品が登場しませんでしたから、シングルスレッドでSIMDとSISDを使うような仕様になっていました。STMを最初に実装したCPUだとPrescottコアのPenitum 4 ●●EGHzと言う末尾にEが付いている製品になりますが、これがSIMDとは別にスレッドが2つあるので、MISDやMIMDの選択肢があるCPUになります。と言っても2スレッドですから、現在のアーキテクチャから考えると、ほとんど何もできないような状態ですが、この時代から、バックグラウンドでレンダリングをしてフォアグラウンドで脚本やラフのデザインやテクスチャを描くなどの作業が出来るようになします。この後に暫くは、STMの未実装の物が登場しますが、Core MAの後のCore InsideシリーズからSMTが実装され始めます。AMDはAMD FXまでは物理コアの性能を求めるような構造にしてありましたが、RyzenからSTMを搭載し、巨大なL3キャッシュを搭載した製品をリリースしています。Core Insideシリーズの登場時でももCore MAの時代やPhonome IIの時代と比較すると、圧倒的にスレッド数の多い状態でしたが、現在のRyzenやCore Insideシリーズは、Core i3やRyzen 3ですら4コア/8スレッドの時代ですから、キャッシュが少ないので上位の製品の用には動作しませんが、スレッド数を分けた処理が出来るようになっています。その為、シングルスレッドの時代のように 【 レンダリングをすると何もできなくなる 】 と言うような状態は存在せず、スレッド数をあらかじめ分けておけば、フォアグラウンドとバックグラウンドの作業を同時進行で行う事が出来るようになっています。

これが、現在の個人用のプロセッサで行える内容ですが、前述のように、 【 ゲーム 】 のような負荷が高い処理に加えてOBSを起動して配信をするような条件だと、CPUやGPUのグレードで出来る事が変わってきますから、結構高負荷な処理を行う事になります。当然、こうした作業ですが、アーキテクチャが古かったり、グレードが低い物だと対応できないので、然るべき物を選ぶ必要がありますが、現在は、高負荷になる処理を同時思考で行うような内容も増えています。

この段階でも結構な負荷になりますが、ここに録画を入れると更に高負荷になってしまうわけですが、ArderLake世代のCore i9ではこれが出来てしまうんドエ凄い状態になっていますが、配信については、今後のアーキテクチャだと 【 ゲームの実行 】 + 【 OBS 】 の組み合わせだと問題なく処理が出来るようになると思われます。OBSの名前が変わってしまったので、今後は 【 Streamlabs(旧:OBS) 】 のような表記になりそうですが、Gefroce RTXシリーズだと、CUDAを使った状態でエンコードをしながら配信と言うのがスタンダードな方法になりますが、今後は阪神だけで考えた場合だと、扱えるゲームの選択肢が増える事は確かです。

このメガタスクの利便性ですが、個人の動画制作のワークフローで考えると、

■ シーケンシャルのノーマライズ

■ 動画の書き出し

■ 3DCGのレンダリング

のように人の作業は必要なくコンピューターが計算をしてファイルを生成する処理と

■ キャラクターモデルのセットアップ

■ 3Dオブジェクトの制作

■ レベルデザイン

■ シーンの構築

■ グレーディング

■ コンポジション

■ 動画の制作

■ アニメーションの制作

■ タイポグラフィー

■ 平面のグラフィックの制作

■ 映像のサムネイルなどの制作

■ モーショングラフィックの制作

■ テキスト関連の作業(企画書、脚本、プロットの制作)

のように人が行う作業に分ける事が出来ます。その為、

■ フォアグラウンド : 人が行う作業

■ バックグラウンド : コンピューターの計算の処理

を同時進行で行えるようになっています。メガタスクと言っても、一人の人間が出来るタスクは 【 1つのみ 】 ですから、先程の人が行える作業の中のいずれかを行う事になりますが、作業の時間帯に何をするのか?を決めて動く必要があります。その為、コンピューターとは別に【 人のスケジュール 】 と言う 【 タスク 】 が存在します。

これを行っている間にハードウェアの性能が高い場合、フォアグラウンドの作業をしてもリソースが余る場合があります。と言う事は、このリソースを演算に使えば、作業をしながら映像の書き出しや結構時間がかかるダイナミクスのBAKEの処理などを行う事が出来るわけです。

当然、こうした作業にも必要となるリソースがありますから、その作業が可能な状態で同時進行をしても弊害が出ないだけのリソースがあった方がいいのですが、動画編集だと、 【 制作した動画の書き出しをする間に、違う動画の編集作業をする 】 と言うワークフローも可能ですし、書き出しをしながらシナリオや企画書を書くこともできますが、この書き出し時のテキスト編集だと現在のPCだとそうした作業が可能な環境は多いので、書き出している間に何もしないというのは時間の無駄なので、通常はそう言ったワークフローを組みます。

つまり、 【 計算している間にアイデアを練るとかはできる 】 ので、

【 脚本やコンテの作業に移りやすいようにアイデア出しをしておいて、その後で企画緒に起こして作業に映る 】 という形にしておくと、計算が終わった後に、別の作業に映るとしてもレンダリング時間分の作業時間を用意する事が出来るわけです。つまり、 【 作業をする人の休憩時間 】 と言うのを入れるとしても、この間にレンダリングは出来るので、 【 同時進行で処理が行えるものが多いほど完成までの時間を短縮できる 】 と言うメリットがあります。

では、メガタスクの場合は何が出来るのか?と言うと、

■ 動画の書き出し

■ ベイク

■ バッチ処理

■ モデリング

のような感じになりますから、こうした無茶な処理を同時進行を行う場合には、処理が出来るだけのハードウェアを用意する事になります。

逆に考えると、所有しているPCのスレッド数やGPU性能とメモリー搭載量で出来る事を模索すると、最低でも

【 演算処理と作業の同時進行 】

が可能になるので、作業効率を飛躍的に向上させることができます。

この時の選択ですが、動画の計算処理ですが、8スレッドで10分の処理が4スレッドで20分になったとします。この時に、4スレッドでグラフィックツールを使ってテクスチャの制作をしたり映像用の素材やエフェクト素材(UVワープやタイルの処理で動く物)を作ったとしても映像の書き出しに何の弊害もなかったとすれば、4スレッドで作業をしていてその裏で気が付いたらその作業が終わっている方が、作業効率は高くなります。

一つのタスクを実行する場合にそう言った処理ができますが、映像のようにショットの繋がったものだと、ショットが完成する必要があります。3DCGAの場合だと、シーン単位で映像を分けて作る事になりますが、このレンダリング処理を行う場合、完成したプロジェクトファイルのシーンの結果をレンダリングする事になります。となると、バッチレンダリングが可能な条件が存在した場合、作業のバックグラウンドで常にレンダリングを行う事が出来るので、フォアグラウンドで別の作業をしながら、バックグラウンドでシーケンシャルの書き出しをすることができます。

3DCGAの場合、シーケンシャルで書き出したほうがいいのですが、この理由はいくつかあって、

■ シーケンシャルだとOpen-EXRが使用できる

■ 途中で落ちても画像は残る

■ 色深度を深くできる

■ RAWが使える

など、何かしらの原因で

■ レンダリング時にエラーが出て止まる

■ ソフトが落ちる

■ PCが落ちる

などの問題が発生しても、画像ファイルは残るので、その落ちたℍジュレーム数からレンダリングを再開するとシーケンシャルの維持が出来るという利点があります。

こうしたワークフローを組むときに、処理能力があるほど出来る事が増えるので、マシンスペックが高いほど時間を効率的に使え、負荷の高い処理にも対応できるので、製作物の品質の選択肢が増えるわけです。

この事例では、

■ フォアグラウンド : 人が行う作業

■ バックグラウンド : コンピューターの計算の処理

になりますが、人の主審中も計算する条件だと、この場合、コンピューターの演算処理をバッチで走らせておくこともできます。この時の考え方ですが、リソースがあれば、

■ 映像の書き出し

■ ダイナミクスのBAKE

なども行えるわけですが、これが1台のコンピューターでできるという事は、この演算処理専用のPCを用意して、製作用のPCでは制作の作業にリソースを全て割り当てると作れる物の選択肢が増えて重たい処理もできるようになります。この構造ですが、

■ ワークステーション

■ レンダリングファーム

の構成を小型化した物になりますが、この間にNASを挟んで、NASにあるデータからレンダリングのリクエストを元にレンダリングをするようにしておくと完成した―プロジェクトファイルや素材をNASに保存しておくだけで計算が出来るようになります。その為、こうした台数が増えた場合だと、2台のPCで同じプロジェクトファイルを使う事になりますから、中間地点にNASを入れて、同じ指定先から同じファイルを参照できるような環境を作る必要があります。そうなると、ツリー構成やパスが同じで、別のマシンのリソースを消費しないNASを用意しておいた方が作業がしやすくなりますから、

■ ワークステーション

■ NAS

■ レンダリングファーム

のような構造になります。個人でこれを組むと、

■ 作業用のマシン

■ NAS

■ 演算用のマシン

と言う構成になりますが、この状態にすると、同じマシンスペックのマシンを2台用意した場合だと、2台のマシンで別のバッチ処理で異なるシーンのレンダリングが出来たり、完成したシーンの編集作業に着手が出来るという利点があります。つあmり、プロジェクトファイルや素材については、ローカルのドライブではなくNASで管理して作業を行うとバッチ処理に特化した演算用のマシンでのファイルの生成(当然、記録先はNAS)をしながら、製作の作業を行いながらプロジェクトファイルを作る(この保存先も当然NAS)事もできます。

PCのスペックで出来る事が違いますが、近年のようにメニーコアのCPUが当たり前にある環境だと、フォアグラウンドとバックグラウンドで作業を行う事が可能になっているので、同じ時間の間に、コンピューターと作業する人がプロジェクトの同時進行をすることで、作業効率を上げる事が出来るようになっています。特に、個人のワンオペのような状態だと、リソースがある程、コンピューターが裏で計算できるものの総数が増えるので、1時間に行える内容を考えた時に出来る作業の量が変わってきます。

とは言っても重たい処理になると演算応力の低いPCだと演算能力が低すぎるので出来る事が限定されてしまいますが、現在の現在のアーキテクチャではそう言った作業が当たり前に行えるようになっています。

スレッドが多い場合、仮想化環境を構築してサーバの学習をする場合に、嘘のようにいろいろな事ができRので知識を深める事が出来るようになっていますが、製作用途のように単一のマシン織ソース内で運用するような条件でも、複数のタスクの同時進行をすることができるので、リソースに合った作業を行うと作業時間を有効に利用する事ができます。その為、オンラインのサービスと言うのは、選択肢の追加でしかありませんから、 【 タスク処理を増やすための選択肢 】 でしかありませんから、基本的な考え方として、マシンで何をするのか?を確定させて運用する事になります。その為、オンラインのレンダリングサービスや環境構築を自由に行えるクラウドサービスなども計算で使うのと、ハードウェアの処理で使うのでは少し内容が違ってきますが、メガタスクで処理をする場合に 【 レンダリング 】 や 【 ベイク 】 のような長時間の演算を行う必要がある処理の作業分担などで使用できる物と考える事が出来ます。

その為、 【 クラウド 】 = 【 オンライン上のリソース 】 でしかありませんから、そのリソースをどう使うのか?は個人で考える必要がありますが、基本的に環境構築が必要な物だと、フォアグラウンドとバックグラウンドで動く物の指定とバッチ処理は可能ですし、計算に特化したものだと、その処理のリクエストを契約内容に合わせて送って計算することになります。(クラウドは、オンラインサービスなので、回線の速度でラグが出ますし、ローカルよりは遅くなるという特性を踏まえて使う事になります。)

現在は単体のコンピューターでできる処理も増えているので、上位の構成だと結構無茶な処理の同時進行が出来るようになっていますから、メガタスクに対応できるようになっており、製作の用途だとワンオペでも 【 計算のみの処理 】 【 人の行う作業 】 で分けて考えると、単体のPCでも同時進行が可能になっています。

おすすめ記事

- ファミコン データック ドラゴンボールZ 激闘天下一武道会 発売日

- ダイパリメイク バトルタワーノーマルクラス制覇!part2

- レトロゲーム スケルトンカバー

- リーダーエフェクト効果一覧表作ってみました。

- 【動画紹介】「スペランカーでも死なない」という比喩?から出合ったゲーム音楽がこれ!ファミコン版?

- 2022u002F01u002F09の体重

- 【ディヴィニティ:OS2 DE】4章クエスト「全滅したキャラバン」と、マイストル・シヴァの救出!

- モナーク(MONARK)のネタバレなしゲームレビュー・感想【辛口注意‼】

- アルトバンのタイヤ交換

- 家族でお出かけ!彩の国さいたま芸術劇場編

- The Sexy Brutale(セクシーブルテイル) プレイ記⑤

- 2022u002F01u002F13 スマホゲーム進捗

- 新日本プロレスクポヾ(。`Д´。)ノ彡ダ―!

- 高難度クエストを乗り越える片手剣装備【mhxx】

- ファークライ5(10日目)

- ファークライ5(12日目)

- 黒い砂漠で陰キャ生活(10日目) 体力ゲージを表示する!

- ドカベン

- ホライゾン 『Horizon Forbidden West』

- ファークライ5(15日目)